Ces derniers temps, il est un euphémisme de dire que les préoccupations d’ordre géopolitique, social et économique sont en ébullition. Dans ce contexte, les conflits et les tendances isolationnistes se multiplient.

Parmi les répercussions de ce marasme, qui semble éloigné du monde de la data, nous pouvons citer les pénuries énergétiques, la fluctuation des devises, les interruptions de la Supply Chain et les marchés en difficulté. On comprend ainsi qu’en tant que professionnels de la data, il va falloir s’adapter aux incidences multiples de ce désordre mondial : une fragmentation accrue, des datacenters disparates, des innovations constantes et des obstacles à l’accès d’une main-d’œuvre qualifiée.

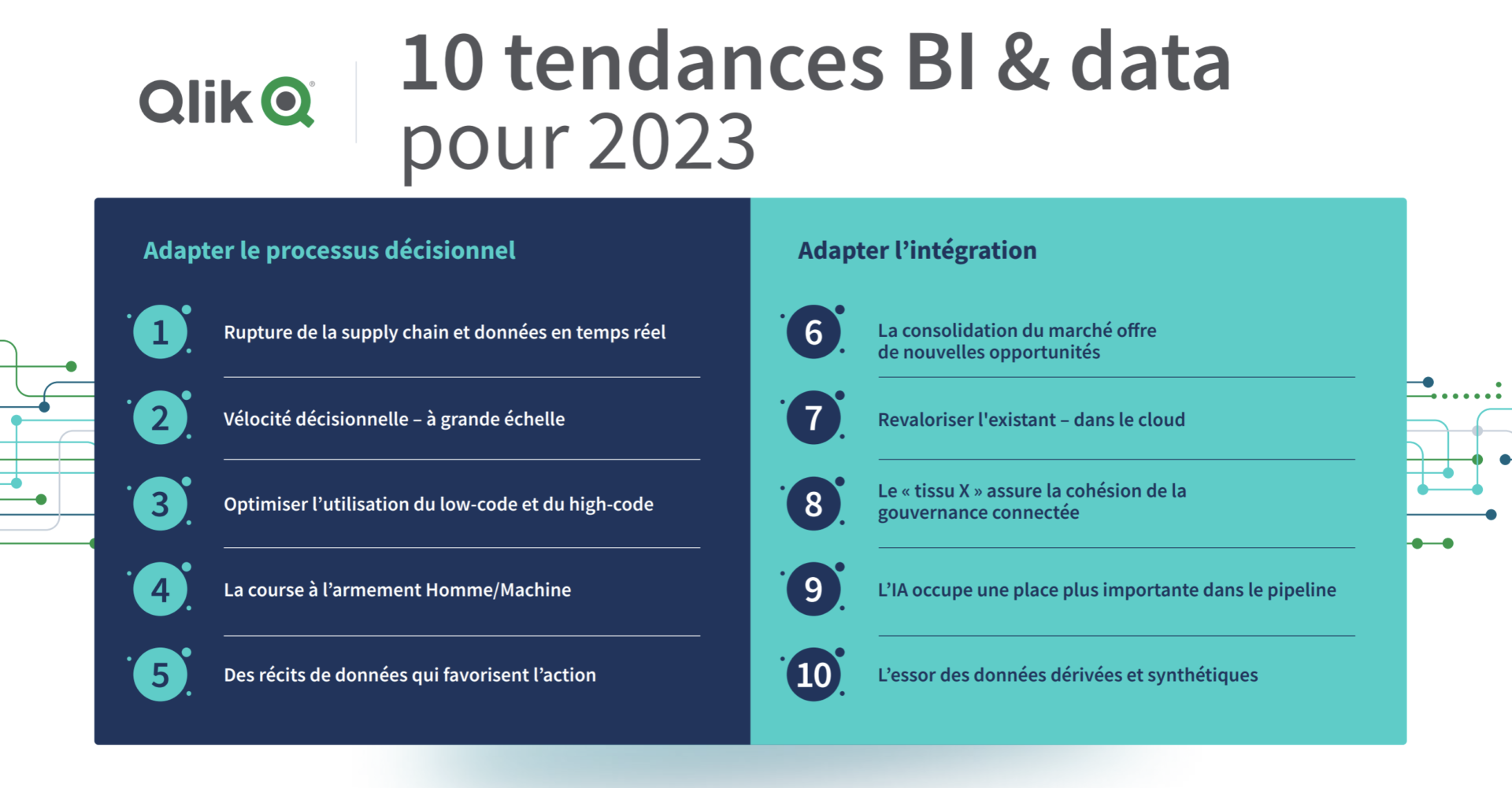

Dans cet article, nous allons explorer les 10 tendances clés identifiées par l’étude Qlik BI & Data Trends 2023 pour anticiper ces changements et se démarquer au cœur d’un contexte incertain

Deux tendances antagonistes du marché de la BI

La fragmentation des données

D’après Gartner, d’ici 2022, plus de 50 % des données d’entreprise seront créées et traitées en dehors du datacenter ou du cloud. À titre de comparaison, cette proportion était inférieure à 10 % en 2019. À l’avenir, la plupart des données seront générées à la périphérie pour être traitées en temps réel. On peut citer comme exemples l’émergence des véhicules autonomes, des villes intelligentes ou encore de la télémédecine.

Cependant, il n’est bien évidemment pas toujours pratique de transférer des données distribuées vers une infrastructure centralisée dans un datacenter ou un cloud public, en vue de les traiter et de les analyser plus tard.

Il est donc crucial de rapprocher l’infrastructure des emplacements périphériques où les données sont produites et traitées. Ce qui soulève de nouvelles questions : comment mettre en place une approche cohérente de gestion de l’infrastructure et des données avec différents fournisseurs de cloud et de nombreux emplacements périphériques ?

La tendance de la convergence et son corollaire : la consolidation de l’offre sont suivies par celle de la demande. Dans les périodes difficiles, les CFO et CEO s’impliquent davantage dans l’entreprise et souhaitent observer un retour sur investissement de manière claire et précise. Les modèles de tarification pourront donc passer d’un format par utilisateur à un accent mis sur la génération de valeur. Après tout, il n’est pas possible de prédéterminer quel membre de votre organisation devrait utiliser quel outil lorsque vous ne savez pas quel sera le prochain défi à relever. C’est pourquoi il faut faciliter l’accès général aux outils et plateformes de manière gouvernée et en faire un point de départ.

Selon l’étude 12 Data and Analytics trends to keep on Your Radar de Gartner, d’ici 2023, le marché de la préparation des données autonomes disparaitra et les fonctionnalités de préparation des données seront intégrées dans des outils de gestion des données, d’analytique et de data science. »

La fin des silos

Au cours des dernières années, le “data stack” n’a cessé de croître et de s’alourdir. De nombreuses organisations ont accumulé un patchwork d’outils et de systèmes disparates pour gérer leurs données, ce qui a donné lieu à une infrastructure complexe et inefficace.

Les causes qui génèrent les silos de données sont nombreuses. Le plus souvent, elles sont liées à l’histoire même d’un système d’information. Celui-ci s’est sûrement bâti au fil des années comme un mille-feuilles d’applications métiers pas toujours conçues dans une logique d’interopérabilité.

Il n’est donc pas surprenant qu’en 2023 (date d’écriture de cet article) la consolidation de la pile de données apparaisse comme une tendance qui promet d’améliorer la rentabilité et de rationaliser les opérations. Ainsi, nous observons la consolidation de systèmes auparavant en silos, notamment l’intégration de données, la gestion, l’analytique/IA, la visualisation, la data science et l’automatisation.

L’optimisation de l’infrastructure de données et la réduction du nombre d’outils et de systèmes utilisés pour gérer les données peuvent permettre d’obtenir une vue plus cohérente et plus fiable des données, garantissant ainsi leur qualité et leur intégrité. La consolidation de la pile de données peut également simplifier le processus de navigation et d’intégration des données provenant de diverses sources, au profit des ingénieurs de données, des scientifiques des données et des autres membres de l’équipe chargée des données.

Cette simplification peut faciliter une meilleure collaboration avec les utilisateurs métier, ce qui permet en fin de compte d’améliorer la prise de décision et de favoriser le succès de l’entreprise.

Les API et normes courantes permettent l’interopérabilité. Lorsqu’un fournisseur agit sur plusieurs segments, la convergence n’en est que plus simple. Il n’est pas question de mettre tous ses pions sur une unique stack de données, ce qui pourrait entraîner une dépendance à un fournisseur et compromettre la conformité. Il s’agit plutôt de choisir des plateformes pouvant fonctionner avec plusieurs stacks et renforcer les données entre les plateformes.

Les 10 tendances BI et Data pour 2023

1. Les données en temps réel

La pandémie et le conflit en Ukraine ont entraîné d’importantes pénuries de composants. Ce contexte a poussé les organisations à mettre à jour leurs pipelines de livraison de données afin de passer des données par batch aux données en temps quasi réel. Avec l’apparition d’un plus grand nombre d’appareils en périphérie – produisant continuellement d’importants flux de données – un plus grand nombre d’opportunités pour exploiter les données en temps réel verront le jour.

Selon, l’étude IDC FutureScape: Worldwide Data and Content Technologies 2022 Predictions, d’ici 2027, 60 % des dépenses en capture de données et technologies de migration se feront sur des pipelines de streaming de données qui ouvriront la voie à une nouvelle génération de simulations, d’optimisations et de fonctionnalités de recommandations en temps réel. »

2. La vélocité décisionnelle

Selon Gartner, 95 % des décisions basées sur les données peuvent être automatisées au moins en partie. De nouveaux rôles verront le jour, axés sur l’innovation décisionnelle – tels que Chief Decision Officer, Decision Designer et Decision Engineer. Ces rôles ne doivent pas uniquement s’atteler à l’automatisation des décisions de routine, mais également s’attaquer aux problématiques majeures les plus épineuses.

D’après IDC, D’ici 2026, 85 % des entreprises allieront l’expertise des individus à l’IA, au ML, au NLP et à la reconnaissance de tendances afin d’élargir les prévisions à travers l’organisation, augmentant ainsi la productivité et l’efficacité des individus de 25 %. »

3. Optimiser l’utilisation du low-code et du high-code

Ces dernières années, nous avons observé l’émergence des outils low-code pour développer les applications, permettant ainsi aux utilisateurs non techniques de créer leurs propres applications.

Parallèlement, les programmeurs et développeurs d’applications de certaines organisations veulent simplement des invites dans lesquelles coder. C’est tout particulièrement le cas dans les domaines de l’ingénierie des données et de la data science, car ils ont été réinventés pour le cloud. Pour pourvoir à ces besoins, nous avons observé l’émergence des outils high-code, qui offrent un modèle aux codeurs souhaitant une flexibilité maximale.

Ces deux camps existeront toujours, même si de nombreux cas d’usage passeront petit à petit du high-code au low-code avec l’identification des workflows répétables et la maturation des marchés. Pour autant, le choix ne devrait pas porter entre le low-code et le high-code. L’accent devrait être mis sur l’optimisation du code, axée sur la meilleure productivité

D’après IDC, « D’ici 2023, 60 % des nouvelles applications seront développées via des plateformes no-code/ low-code, soit 30 % de plus qu’actuellement. » et les meilleurs résultats métier en fonction des ensembles de compétences à votre disposition

4. Le développement des agents conversationnels

Dans le secteur de la data et analytique, les fonctionnalités de langage naturel Les modèles de langage naturel ayant été formés à partir de quantités massives de données via un machine learning par réseau de neurones profond, ils ont atteint un changement de paradigme. Le modèle dont nous entendons le plus parler est probablement GPT‑3. Prédiction des analystes « Il y a désormais 5 ou 6 développements internationaux encore plus puissants que GPT-3¹¹, des modèles formés sur des ensembles de données encore plus vastes. Il est difficile d’imaginer où cela peut nous mener. Il est probable que nous soyons sur le point de franchir l’actuelle frontière et que des machines pourront réussir le test de Turing. auront un rôle très important à jouer concernant la manière dont nous demandons les informations et dont nous les interprétons et rapportons. Nous trouverons non seulement les données que nous recherchions, mais aussi celles que nous n’avions pas pensé à demander.

D’ici cinq à dix ans, voire plus tôt, Forrester Research prévoit sur la base des innovations révolutionnaires observées avec l’IA, des agents conversationnels réussissant le test de Turing seront créés par plusieurs fournisseurs de technologies.

5. L’avènement du Data storytelling pour favoriser la prise de décisions

Pour relier le storytelling aux actions vous devez ajouter trois étapes : 1. Prédire les prochains événements et suggérer les meilleures actions à entreprendre avec AutoML 2. Utiliser les alertes, le reporting et l’automatisation pour intégrer les récits dans les workflows au moment opportun 3. Intégrer des tableaux de bord, mais aussi des microrécits, dans les systèmes utilisés par les individus. Ce processus fera passer le storytelling de données des informations exploitables aux informations exploitées.

D’ici 2025, les récits de données seront la méthode la plus courante pour consommer l’analytique et 75 % des récits seront automatiquement générés via des techniques d’analytique augmentée selon Gartner.

6. La couche sémantique

Les applications de BI traditionnelles couplent souvent étroitement la modélisation et la visualisation des données, ce qui rend difficile la maintenance et la mise à jour de l’application au fil du temps.

Imaginez que vous deviez constamment réécrire des visualisations parce que le modèle de données sous-jacent a changé. Il s’agit d’un processus frustrant et chronophage qui entrave l’agilité des organisations dans un environnement commercial en constante évolution. L’année dernière, nous avons vu l’approche de la couche sémantique rattraper finalement d’autres tendances.

Par exemple, dbt a introduit une fonctionnalité appelée couche sémantique. Au début, elle était accessible en tant qu’aperçu public et maintenant elle a été ajoutée à la liste officielle des fonctionnalités. Google a fait pression pour intégrer les modèles sémantiques de Looker dans ses autres produits. Microsoft a introduit Datamarts en tant que fonction de prévisualisation dans Power BI. Ce n’est qu’un début, mais c’est un pas dans la bonne direction. Je suis très curieux de savoir comment la couche sémantique va évoluer et quel taux d’adoption nous verrons cette année.

7. La migration dans le cloud

Sur le plan financier, il n’est pas viable pour les organisations de travailler avec une pléthore de fournisseurs de niche. Bien heureusement, nombre de ces fonctionnalités seront récréées dans les plus vastes plateformes de data et analytique intégrées. Les marchés du cloud murissant, les managers pourraient délaisser les architectures s’appuyant trop sur un trop grand nombre de startups immatures en difficulté. Ces startups pourraient plutôt être mises à profit en tant que source d’« acqui-hiring ».

Pour remédier à la pénurie de compétences en développement informatique, d’ici 2024, 55 % des organisations feront des marketplaces dans le cloud et des acquisitions de startups technologiques leur principale approche dans le cadre du sourcing logiciel. » d’après IDC.

8. Le « tissu X »

Dans un monde composé de millions de générateurs, nous avons besoin d’autres tissus, les « tissus X. » Ils comprennent les tissus d’applications, les tissus de BI et les tissus d’algorithmes. Actuellement, ces méthodologies sont encore moins matures que la data fabric.

Les tissus X sont nécessaires dans le cadre d’une gouvernance connectée. Vous devez aussi certifier les artéfacts en fonction de leur degré de fiabilité – par exemple via des filigranes basés sur des paliers. De nos jours, toutes les organisations cherchent de meilleures méthodes d’accès à leurs artéfacts de data et analytique. Dans un monde distribué, l’orchestration est encore plus importante.

D’ici 2023, 60 % des entreprises classées au Global 2000 disposeront d’une architecture de plan de contrôle des données pour favoriser les DataOps, booster l’ingénierie des données basée sur le ML, réduire les risques liés aux données et stimuler l’innovation par les membres de la génération data (Gen D) selon IDC.

9. L’IA

L’analytique, l’automatisation et l’IA convergent et se superposent de plus en plus. Ce faisant, elles entrent dans un processus d’hybridation, générant de nouvelles informations jusque-là impossibles à obtenir.

Plus d’IA dans le pipeline de données ne signifie pas pour autant que les individus n’auront aucun rôle à jouer. Après tout, les êtres humains excellent lorsqu’il s’agit de synthétiser les problèmes complexes à composantes multiples. Mais l’IA automatisera certaines des tâches de préparation de données les plus manuelles, afin que les ingénieurs data et data scientists puissent se concentrer sur des tâches ayant un impact plus important.

En 2024, les tâches d’intégration manuelle des données seront réduites de jusqu’à 50 % via l’adoption de modèles de conception de data fabric qui prennent en charge l’intégration de données augmentées d’après Gartner.

10. L’essor des données dérivées et synthétiques

Grâce à plusieurs facteurs – notamment la réutilisation des données, les tests, les lois de confidentialité, les données manquantes et la nécessité de disposer de données pour former les modèles d’IA – nous verrons de plus en plus de données dérivées et synthétiques.

D’ici 2030, les données synthétiques auront entièrement éclipsé les données réelles utilisées pour les modèles d’IA. selon Gartner.

Cela pourrait vous intéresser

Connect

Pour recevoir nos derniers articles sur la Data et l'Intelligence Artificielle, abonnez vous à Connect, l’email qui fait du bien à vos données.

Vous souhaitez plus d'actualités exclusives sur la data et l'IA ?

Inscrivez-vous à notre newsletter mensuelle Connect ! Recevez une fois par mois un concentré d’actualités, événements, interviews, documentation sur les domaines data, IA et Cybersécurité.